Arbeiter:innen in Kenia sollten teils traumatisierende Texte lesen, um ChatGPT zu optimieren. Ihr Stundenlohn: bis zu zwei US-Dollar. Eine Recherche des Time Magazines zeigt: Hinter dem Hype um die Künstliche Intelligenz steckt auch eine Geschichte von Ausbeutung im globalen Süden.

Jede Menge Nutzer:innen reden derzeit über und mit ChatGPT. Der mächtige Text-Generator lässt sich in Dialoge verwickeln, erstellt auf Anfrage Essays zu den entlegensten Themen, Gedichte verschiedener Stilrichtungen, komplexe Programmcodes und vieles mehr. Nun zeigt eine Recherche des US-amerikanischen Time Magazine, welche Rolle schlecht bezahlte Arbeiter:innen aus Kenia bei der gehypten Anwendung spielen.

ChatGPT stammt von OpenAI, einem US-Unternehmen mit Sitz in Kalifornien. Nachdem OpenAI das Programm im November vergangenen Jahres veröffentlicht hatte, verzeichnete es schon nach nur einer Woche eine Million Nutzer:innen. Innerhalb kurzer Zeit stieg OpenAI zu einem der wertvollsten KI-Firmen weltweit auf. Neben ChatGPT bietet OpenAI den Bild-Generator DALL-E-2 an. In naher Zukunft will das Unternehmen darüber hinaus Anwendungen anbieten, die Videos und menschliche Stimmen generieren.

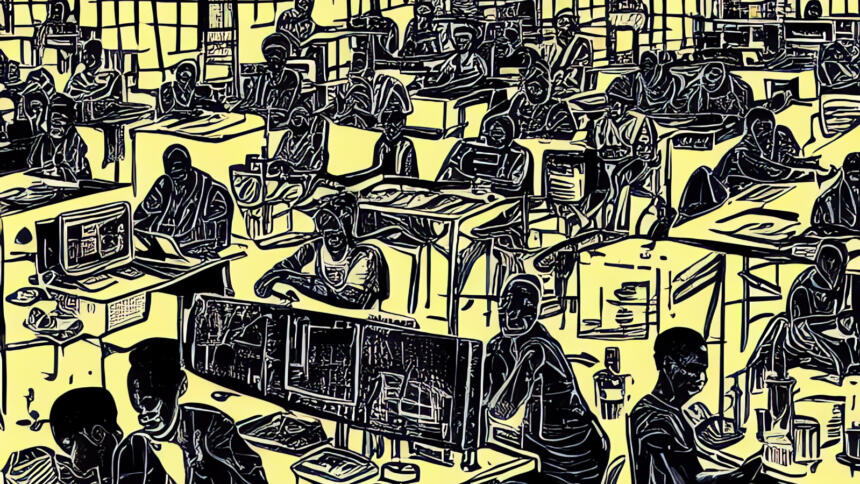

Der Erfolg von ChatGPT beruht nicht nur auf Codezeilen und Datenbanken, sondern auch auf mühsamer Handarbeit. Denn bevor Millionen Nutzer:innen mit ChatGPT ins Gespräch kamen, haben Arbeiter:innen in Kenia unter prekären Bedingungen die Anwendung optimiert. Sie haben dazu beigetragen, dass die Antworten des Text-Generators „weniger toxisch“ ausfallen, wie aus der Times-Recherche hervorgeht.

Dass auch sogenannte „Künstliche Intelligenz“ nicht ohne menschliche Hilfe auskommt, ist zunächst nicht neu oder überraschend. Auch Konzerne wie Google setzen dafür Menschen ein. Der neue Bericht liefert allerdings einen eindrücklichen Einblick in die Arbeitsbedingungen hinter den Kulissen. Die Tätigkeit wird dabei nicht etwa zum US-Mindestlohn im Silicon Valley verrichtet, sondern verstärkt in den globalen Süden ausgelagert – mit schlechten Arbeitsbedingungen. In diesem Fall hat das von OpenAI beauftragte Unternehmen Samasource die Zusammenarbeit vorzeitig beendet.

Für die Recherche hat das Time Magazine Hunderte Seiten interner Dokumente von Samasource und OpenAI geprüft und vier Mitarbeitende interviewt, die an dem Projekt gearbeitet haben.

Zwei US-Dollar pro Stunde

Wie OpenAI hat die auch als Sama bekannte Firma ihren Hauptsitz in San Francisco. Samas Angestellte leben dagegen vorwiegend in Kenia, Uganda und Indien, wo sie unter anderem Daten kennzeichnen und kategorisieren. Nach eigenen Angaben habe Sama dabei geholfen, mehr als 50.000 Menschen aus der Armut zu befreien.

Im Auftrag von OpenAI beschäftigte Sama seit November 2021 rund drei Dutzend Arbeiter:innen in Kenia. Ihre Aufgabe bestand darin, Textausschnitte auf schädliche Inhalte hin zu lesen und zu markieren. Die entsprechenden Passagen wurden dann in ein Datenset übertragen, mit dem OpenAI einen Sicherheitsmechanismus auf KI-Basis trainierte. Die sogenannten pre-training filter dienen dazu, schädliche Textpassagen aus den Trainingsdaten von ChatGPT zu entfernen. Die Grundlage für diese Trainingsdaten bilden Texte, die OpenAI zuvor massenhaft aus dem Internet geschürft hatte.

Die Arbeitskräfte müssen also Inhalte sichten und aussortieren, weil spätere ChatGPT-Nutzer:innen von ähnlichen Inhalten verschont werden sollen. „Die Klassifizierung und Filterung von schädlichen [Texten und Bildern] ist ein notwendiger Schritt, um die Menge an gewalttätigen und sexuellen Inhalten in den Trainingsdaten zu minimieren und Werkzeuge zu entwickeln, die schädliche Inhalte erkennen können“, so ein Sprecher von OpenAI gegenüber dem Time Magazine.

In einer neunstündigen Schicht mussten die Arbeiter:innen bis zu 250 Textpassagen von einer Länge bis zu 1.000 Wörtern lesen, wie aus der Recherche hervorgeht. Zum Vergleich: Dieser Text enthält rund 800 Wörter. Im Gegenzug erhielten die Arbeiter:innen – je nach Dienstalter und Leistung – einen Stundenlohn zwischen 1,32 und 2 US-Dollar. Das entspricht laut Times in etwa dem Gehalt einer Empfangsangestellten in einem Hotel in Nairobi.

OpenAI bezahlte Sama einen vertraglich festgelegten Stundensatz in Höhe von 12,50 Dollar – und damit bis zu neun Mal mehr als die Arbeiter:innen pro Stunde bekamen. Dieser Betrag habe jedoch sämtliche Kosten des Unternehmens abdecken müssen, rechtfertigt ein Sama-Sprecher die Differenz.

„Vom ständigen Nachdenken verstört“

Für ihr Gehalt mussten die Arbeiter:innen mitunter Beschreibungen lesen, die lebhafte Darstellungen unter anderem von sexueller Gewalt, Suiziden und Tierquälerei enthielten. „Das war Folter“, sagte einer der Arbeiter gegenüber dem Time Magazine. „Man liest im Laufe der Woche etliche solcher Beschreibungen. Und wenn es dann Freitag wird, ist man vom ständigen Nachdenken darüber verstört.“

Um die zum Teil traumatisch wirkenden Darstellungen zu verarbeiten, hätten die Arbeiter:innen um psychologische Unterstützung gebeten. Diese habe Sama ihnen aber nur eingeschränkt gewährt. Das Unternehmen widerspricht dieser Darstellung, wie das Time Magazine berichtet: Es habe für die Arbeiter:innen „jederzeit“ die Möglichkeit bestanden, sowohl an therapeutischen Gruppensitzungen als auch an Einzelgesprächen mit professionellen Therapeut:innen teilzunehmen.

Im Februar 2022 beauftragte OpenAI Sama mit einem weiteren Projekt, das die Kategorisierung von Bildern vorsah, heißt es im Bericht. Einige der Bilder sollen demnach Gewalt an Kindern, Morde und Vergewaltigungen gezeigt haben. Unter US-amerikanischem Gesetz soll der Inhalt einiger der Darstellungen verboten gewesen sein.

Wenige Wochen später löste Sama den Vertrag mit OpenAI vorzeitig auf, acht Monate vor dessen Ablauf. Das heißt, die Arbeiter:innen müssen seitdem nicht länger verstörende Daten für OpenAI sichten. Allerdings mussten die meisten von ihnen daraufhin weniger gut bezahlte Tätigkeiten übernehmen, berichtet das Magazin, andere verloren ihre Anstellung. Sama hat nach eigenen Angaben inzwischen seine Leitlinien überarbeitet. Kürzlich gab das Unternehmen bekannt, aus dem Geschäft mit Inhaltemoderation auszusteigen.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

0 Commentaires