Seit dem Hype um ChatGPT richten sich viele Blicke auf den geplanten AI Act. Die EU-Verordnung zu „Künstlicher Intelligenz“ ist seit Jahren in der Mache und soll morgen im Parlament eine nächste Hürde überwinden. An mindestens sechs Stellen lauern Probleme.

Der AI Act soll das weltweit erste Gesetz werden, das „Künstliche Intelligenz“ (KI) umfassend reguliert. Dabei geht es nicht nur um seit kurzem gehypte Dienste wie ChatGPT. Die EU-Verordnung handelt etwa auch von Kameras am Bahnhof, die verdächtige Bewegungsmuster erfassen sollen, oder von Software in der Personalabteilung, die Bewerbungen sortiert. Vor allem aber soll die Verordnung rote Linien ziehen, in welchen Bereichen KI auf keinen Fall zur Anwendung kommen soll, etwa beim Social Scoring. So nennt man Punktesysteme, die Bürger:innen für unerwünschtes Verhalten bestrafen.

Am morgigen 11. Mai soll die KI-Verordnung eine weitere Hürde nehmen. An diesem Tag stimmen zwei wichtige Ausschüsse über den aktuellen Entwurf ab, auf den sich die Verhandler:innen des EU-Parlaments vor rund zwei Wochen geeinigt haben. Voraussichtlich Mitte Juni soll das Plenum des EU-Parlaments dann grünes Licht geben für den sogenannten Trilog, also die Verhandlungen zwischen Parlament, Ministerrat und Kommission über das endgültige Gesetz.

Ob die KI-Verordnung am Ende aber der versprochene große Wurf wird, muss bezweifelt werden. Denn die im April 2021 von der Kommission als Entwurf vorgelegte Verordnung weist zahlreiche Leerstellen auf, die ausgerechnet beim KI-Einsatz durch staatliche Behörden und das Militär besonders groß ausfallen. Weitere Lücken klaffen bei Fragen der Transparenz sowie der Möglichkeit von Betroffenen, sich gegen Diskriminierung durch KI-Systeme zu wehren. Die Übersicht.

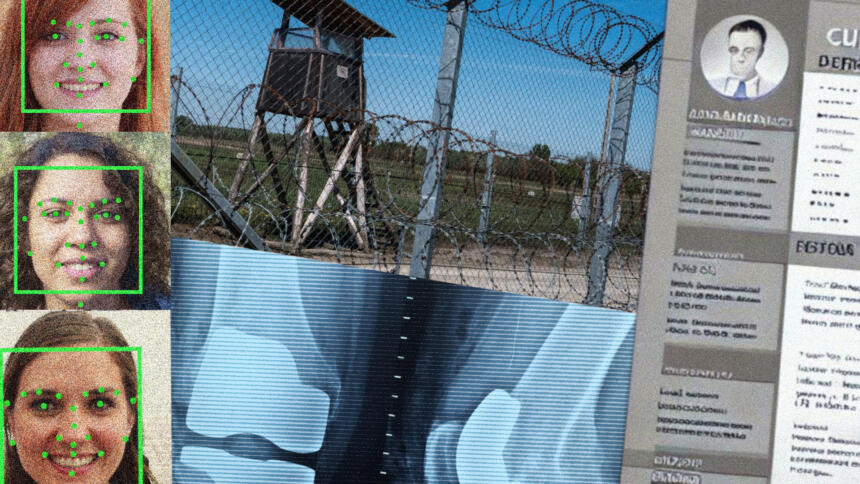

1. Der AI Act soll staatliche, biometrische Massenüberwachung absegnen

Besonders aufmerksam verfolgen Bürgerrechtsgruppen die Debatte darum, wie die KI-Verordnung biometrische Überwachung regulieren soll. Durch Biometrie – etwa einzigartige Merkmale im Gesicht – lassen sich Menschen identifizieren und massenhaft überwachen, gegebenenfalls auch in Echtzeit. Die Technologie bedroht damit unter anderem Privatsphäre und Versammlungsfreiheit.

Die Kommission möchte den Staaten in ihrem Entwurf beim Einsatz biometrischer Überwachung einige Freiheiten lassen. Zwar stuft sie solche Systeme als „hochriskant“ ein, möchte aber sogenannte „biometrische Echtzeit-Fernidentifizierungssysteme“ in öffentlich zugänglichen Räumen zu Strafverfolgungszwecken dennoch zulassen. Das Parlament sieht dagegen strengere Regeln vor. Demnach zeichnet sich ab, dass die Abgeordneten zumindest den Einsatz biometrischer Überwachung in Echtzeit mehrheitlich ablehnen. Zugleich aber lassen sie die sogenannte retrograde Identifizierung im Nachhinein unter bestimmten Bedingungen zu. Diese wäre beispielsweise erlaubt, wenn sie gerichtlich genehmigt und im Zusammenhang mit schweren Straftaten steht.

Doch auch mit dieser Einschränkung würde die KI-Verordnung einer neuen Form der Massenüberwachung und Vorratsdatenspeicherung den Weg ebnen. Denn auch für eine eingeschränkte retrograde Identifizierung müssten Behörden fortan Videoaufnahmen in großem Umfang erstellen – also den öffentlichen Raum überwachen – und über einen längeren Zeitraum speichern. Und um diese Aufnahmen abzugleichen, etwa mit dem Gesicht eines gesuchten Verdächtigen, müssten sie zudem biometrische Daten in großem Umfang sammeln und Strafverfolgungsbehörden verfügbar machen.

Für die sogenannte retrograde Videoüberwachung spricht sich auch die Bundesregierung aus – obwohl der Koalitionsvertrag das explizit ausschließt. Dort heißt es: „Flächendeckende Videoüberwachung und den Einsatz von biometrischer Erfassung zu Überwachungszwecken lehnen wir ab. Das Recht auf Anonymität sowohl im öffentlichen Raum als auch im Internet ist zu gewährleisten.“

2. Die Verordnung begünstigt militärische KI-Aufrüstung

Mindestens ebenso gravierend ist eine große Ausnahme, die bereits im Entwurf der EU-Kommission vorgesehen ist: „Diese Verordnung gilt nicht für KI-Systeme, die ausschließlich für militärische Zwecke entwickelt oder verwendet werden.“

Das ist nichts anderes als ein Freifahrtschein für das Militär. Davon profitiert unter anderem die NATO. Das Militärbündnis aus 31 europäischen und nordamerikanischen Mitgliedstaaten hat im Februar angekündigt, einen Zertifizierungsstandard für KI zu erarbeiten. Der Standard soll die Prinzipien umsetzen, die die NATO im Oktober 2021 in ihrer KI-Strategie verabschiedet hat, und legt den Fokus unter anderem auf autonome Waffensysteme.

Damit aber versäumt es die EU, den Einsatz von KI im Rahmen ihrer gemeinsamen Außen- und Sicherheitspolitik zu regulieren und dabei auch auf entsprechende Ambitionen ihrer Mitgliedsstaaten Einfluss zu nehmen – was sie durchaus könnte. So verfolgt innerhalb der Union allen voran Frankreich bereits seit Jahren eine militärische KI-Strategie. Hinzu kommt: Je weniger der militärische Bereich reguliert ist, desto größer ist die Gefahr eines globalen Rüstungswettlaufs.

Immerhin würde die geplante Verordnung sogenannte Dual-Use-Systeme strenger regulieren. So nennt man Technologien, die sowohl im zivilen als auch im militärischen Bereich eingesetzt werden. Brisant ist dabei jedoch die Frage, wo genau die Grenze verläuft: Dürfte das Militär beispielsweise auf Forschungsergebnisse und Produkte ziviler Einrichtungen zurückgreifen, um damit eigene Forschung zu betreiben oder gar Waffensysteme zu entwickeln?

3. Staaten wollen gefährliche KI-Systeme für die „nationale Sicherheit“ einsetzen

Bei den Verhandlungen zum geplanten AI Act versuchen einige EU-Staaten und Abgeordnete, weitere Lücken ins Gesetz zu reißen. Konkret geht es um Ausnahmen bei Belangen der „nationalen Sicherheit“. Der von der slowenischen EU-Ratspräsidentschaft angenommene Kompromisstext hat diese Forderung bereits im November 2021 übernommen, der Rat hat das ein Jahr später bekräftigt.

Mit Verweis auf die „nationale Sicherheit“ könnten selbst autokratische EU-Regierungen wie etwa die in Ungarn nach Belieben selbst gefährlichste KI-Systeme einsetzen. Darunter fallen, selbst wenn die KI-Verordnung das zunächst untersagt, auch biometrische Massenüberwachung oder Social Scoring für EU-Bürger:innen.

Dass dies dem Missbrauch geradezu Tür und Tor öffnet, zeigt nicht zuletzt die staatliche Spionagesoftware Pegasus, angeboten von der israelischen NSO Group. Diese Technologie wurde laut Herstellerangaben ausschließlich für Zwecke der nationalen Sicherheit entwickelt. Inzwischen ist bekannt, dass auch Oppositionelle, Journalist:innen und Dissident:innen in der EU ins Visier gerieten. Nicht nur in Ungarn und Polen, sondern auch in Griechenland und Spanien.

Das EU-Parlament hat diese Gefahr offenbar erkannt. Der Kompromissentwurf, über den morgen abgestimmt wird, beschränkt sich auf die Ausnahmen für militärische Nutzung. Ob der Rat sich damit zufriedengibt oder weiterhin auf die „nationale Sicherheit“ als Ausnahme pocht, wird sich in den Trilog-Verhandlungen zeigen.

4. Es soll weiter aggressive KI-Systeme an den Außengrenzen geben

In den vergangenen Jahren hat die EU ihre Außengrenzen massiv mit KI-Systemen aufgerüstet. Sie kontrolliert und überwacht Menschen, die sich in die EU hineinbewegen, und verwandelt die Grenze zum Experimentierlabor für neue Technologien. Ob biometrische Gesichtserkennung, Überwachungsdrohnen über Geflüchtetencamps oder Scannen nach angeblich verdächtigen Bewegungen – vieles, was beim Einsatz gegen EU-Bürger:innen für einen Aufschrei sorgen würde, scheint an der Grenze akzeptabel. Auch im Asylprozess kommen KI-Systeme zum Einsatz, etwa die Software zur Dialekterkennung, mit der das Bundesamt für Asyl Hinweise auf die Herkunft von Geflüchteten sucht.

Auf den ersten Blick nimmt der Entwurf des AI Act die Probleme dieser Technologien ernst: „KI-Systeme, die in der Migrations-, Asyl- und Grenzverwaltung eingesetzt werden, betreffen Menschen, die sich oft in einer besonders verletzlichen Lage befinden und von den von den Ergebnissen der Maßnahmen der zuständigen Behörden abhängig sind.“ Der Entwurf stuft die Technologien daher als hochriskant ein; hier seien Grundrechte in Gefahr.

Doch unterm Strich dürfte der AI Act am Einsatz der Technologien wenig ändern – nicht einmal dort, wo KI-Systeme größte Gefahren für das Leben, die Sicherheit und weitere Menschenrechte darstellen. So dürfte die EU-Grenzagentur Frontex weiterhin das Mittelmeer oder Grenzzäune mit autonomen KI-Systemen überwachen, auch wenn dies womöglich zu illegalen Pushbacks führt und Menschen dadurch ihr Recht auf Asyl nicht wahrnehmen können. Selbst wissenschaftlich umstrittene Technologien wie etwa der „KI-Lügendetektor“ AVATAR dürften weiter an den EU-Grenzen zum Einsatz kommen .

Zivilgesellschaftliche Organisationen wie Edri und Amnesty International halten das für fahrlässig und fordern seit langem Änderungen am Gesetzentwurf. Die Aussichten für den besseren Schutz von Grundrechten an der EU-Grenze dürften jedoch gering sein. Erst kürzlich haben EU-Staaten etwa ein neues System geschaffen, das einzelne Personen einer datenbasierten Risikoanalyse unterzieht: das Reisegenehmigungssystem ETIAS.

Ab Ende des Jahres muss jede Person, die den Schengenraum ohne Visum betreten will, vorher einen Antrag stellen. Ihre Daten werden automatisch mit zahlreichen Datenbanken abgeglichen und auf Risiken überprüft. Die Technologie dahinter ist für Betroffene undurchsichtig und wird das auch bleiben, wenn der AI Act nicht nachbessert. Voraussichtlich darf die EU weiterhin von „AI border guards“ schwärmen, die in Zukunft angeblich lügende Ausländer:innen anhand von Körpersprache erkennen sollen.

5. Es fehlen Rechte für Betroffene, um sich zu wehren

Als eines ist der AI Act sicher nicht geplant worden: als Gesetz zum Schutz von Verbraucher:innen. Im Gegenteil: Im Entwurf der Kommission waren keine direkten Beschwerde-Mechanismen für die Menschen vorgesehen, deren Grundrechte von solchen Systemen verletzt wurden.

Hier versucht der EU-Rat gegenzusteuern. Dessen Position sieht vor, dass Personen bei der zuständigen Aufsichtsbehörde eine Beschwerde einreichen können. Die Organisation AlgorithmWatch weist aber darauf hin, dass diese Rechte nicht annähernd weit genug gehen. AlgorithmWatch fordert unter anderem: „Betroffenen selbst sollte ein Recht auf Information und auf Erklärung zugesprochen werden, da Transparenz die Voraussetzung dafür ist, dass algorithmische Diskriminierung erkannt wird und Betroffene geeignete Rechtsmittel ergreifen können.“

Trotz der Lücken im geplanten AI Act gibt es Gesetze, die Betroffene von Diskriminierung durch KI-Systeme schützen können. Zum Beispiel müssen große Online-Plattformen laut Digitale-Dienste-Gesetz künftig einschätzen, welche Risiken sie verursachen und etwas dagegen unternehmen. Betroffene von Diskriminierung können sich in Deutschland auf das Allgemeine Gleichbehandlungsgesetz berufen. Und in der DSGVO (Datenschutzgrundverordnung) steht sogar ein Schutz vor automatisierten Entscheidungen, die Menschen beeinträchtigen.

Darüber hinaus hat die Kommission im vergangenen September einen neuen Richtlinienentwurf vorgestellt. Er zielt auf algorithmische Entscheidungssysteme ab und soll klären, wer haftet, wenn ein KI-System Schäden verursacht – etwa, wenn fehlerhaftes Datenmaterial zu Diskriminierung bei der Kreditvergabe oder im Bewerbungsverfahren führt.

Verbände wie Beuc, Edri oder Amnesty International finden allerdings, in der Praxis hilft das zu wenig. Sie haben gehofft, der AI Act könnte die Chance nutzen und Lücken schließen. Die wichtigen Ausschüsse im EU-Parlament haben hierfür bereits grundlegende Anpassungen im Gesetz vorgesehen.

6. Weiche Definitionen können den AI Act zahnlos machen

Gut gemeint ist nicht gleich gut gemacht – das beschreibt eine weitere und obendrein grundlegende Schwäche des AI Act treffend. Das beginnt bei der Definition von „KI-Systemen“, um die sicherlich noch gerungen wird. Diese Definition hat großen Einfluss darauf, wer sich an strengere Regeln halten muss – und wer nicht. Soll die KI-Verordnung nur maschinelles Lernen regulieren oder auch viele andere Dinge, die sich „KI“ nennen? Unter anderem die SPD warnte Anfang des Jahres vor einer zu engen Definition. Das Argument: Potentiell gefährliche Anwendungen könnten durchs Raster fallen.

Die Frage nach der Definition ist so grundlegend, sie könnte die hehren Ziele des AI Acts untergraben. Im weiten Sinne ist KI ein Sammelbegriff für Anwendungen, die viele Daten zueinander in Beziehung setzen und auf dieser Grundlage Antworten berechnen. Und ausführlich beschreibt der Entwurf der Kommission, was bei KI-Systemen alles schiefgehen kann. Sie können demnach die Menschenwürde verletzen und die Privatsphäre einschränken; sie können sexistisch und rassistisch sein oder Menschen mit Behinderung benachteiligen. Die Liste von Hochrisiko-Systemen ist umfassend und reicht von Lügendetektoren über Deepfake-Erkennung bis hin zu Software, die kriminelles Verhalten vorhersagen soll, sogenanntes Predictive Policing.

Ampel verpasst Grundrechteschutz bei der Regulierung künstlicher Intelligenz

Das führt direkt zum nächsten Problem mit Definitionen: Um diese und weitere Gefahren einzudämmen, sollen die Daten hinter solchen KI-Systemen „hinreichend relevant, repräsentativ, fehlerfrei und vollständig sein“. Das klingt traumhaft, aber dieses Ziel zu erreichen, ist leichter gesagt als getan. Streng genommen beschreiben die Worte eine Utopie, denn riesige Datensätze sind nie „frei“ von Fehlern. Und das Wort „repräsentativ“ wirft die Frage auf, was genau die Daten eines KI-Systems repräsentieren sollen. Denn oft spiegeln KI-Systeme gerade die Missstände einer sexistisch und rassistisch strukturierten Realität wider und drohen, diese noch weiter zu verfestigen – und das wäre wohl kaum im Sinne der Gesetzgeber:innen.

Pragmatische Lösungen sind dennoch denkbar, das zeigt etwa ein Fachartikel des deutschen Rechtswissenschaftlers Philipp Hacker in der Zeitschrift „Law, Innovation and Technology“. Darin macht ein konkretes Beispiel anschaulich, was hinter einem Begriff wie „repräsentativ“ stecken kann: „Wenn die KI eines autonomen Fahrzeugs während des Trainings hauptsächlich mit Menschen weißer Hautfarbe konfrontiert wird, kann es sein, dass sie Menschen dunklerer Hautfarbe nicht oder weniger oft erkennt.“ Im besten Fall kann der AI Act also Entwickler:innen dazu verpflichten, solche Fehler in den Trainingsdaten zu vermeiden.

Was die Verordnung letztlich bewirken kann, hängt also auch maßgeblich davon ab, wie der Gesetzgeber solche Begriffe wie „KI-System“ und „hinreichend repräsentativ“ ausgestaltet. Selbst wenn sich der AI Act durch seinen Namen als das KI-Gesetz schlechthin darstellt – er bildet letztlich nur einen Baustein von etwas Größerem. Es liegt nun an den Organen der EU, wie wichtig dieser Baustein wird.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

0 Commentaires