Versteckte Datenschutzeinstellungen, voreingestellte Cookie-Banner, unnötig komplizierte Prozesse beim Löschen von Accounts: Dass Online-Anbieter:innen ihre Nutzer:innen mit Gestaltungstricks relativ leicht manipulieren können, ist Daten- und Verbraucherschützer:innen schon lange ein Dorn im Auge. Jetzt haben die europäischen Datenschutzbehörden Richtlinien veröffentlicht, die am Beispiel Sozialer Netzwerke helfen sollen, derlei unethisches Design zu erkennen und zu verhindern.

„Dark Patterns“ werden diese unsichtbaren Muster bei der Gestaltung von Benutzeroberflächen und Entscheidungsprozessen im Netz genannt, mit denen Nutzer:innen zu einer bestimmten Auswahl geleitet werden sollen. Die Gestalter:innen von Online-Umgebungen machen sich dabei zunutze, dass viele Menschen im Netz ähnliche Verhaltensmuster an den Tag legen. Dass sie etwa in der Hektik des Alltags oft die Option auswählen, die für sie am wenigstens Klick-Arbeit bedeutet. Oder dass sie sich durch bestimmte Design-Tricks davon abhalten lassen, eine bestimmte Option auszuwählen. Weil sie dabei auf verhaltenspsychologische Forschung zurückgreifen und täglich das Verhalten von abertausenden Menschen beobachten können, herrscht ein Machtungleichgewicht.

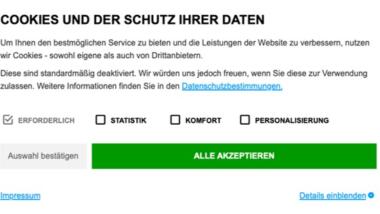

Erst Mitte März deckten Journalist:innen des Business Insider auf, dass Amazon durch Design-Tricks bewusst versucht hat, die Kündigung des Bezahldienstes Amazon-Prime zu erschweren. Offenbar mit Erfolg: Das „Projekt Iliad“ soll die Kündigungsrate um 14 Prozent gesenkt haben. Auch zur Abwehr von Datenschutzbemühungen setzen Unternehmen auf Dark Patterns. Die österreichische Nichtregierungsorgansiation NOYB hat 2021 zum Beispiel hunderte Beschwerden wegen Cookie-Bannern eingereicht, die durch die farbliche Gestaltung oder andere Tricks dazu verleiten sollen, einfach alle Überwachungsmaßnahmen zu akzeptieren.

Typologie der Design-Tricks

In den gut 60-seitigen Guidelines machen die europäischen Datenschutzbehörden deutlich, dass das Phänomen längst nicht auf Cookie-Banner beschränkt ist. Anhand des Lebenszyklus eines Social-Media-Accounts – von der Erstellung bis zur Löschung – machen sie anschaulich, wie vielfältig die Beeinflussungsversuche im Netz.

Und sie zeigen, dass viele davon mit der Datenschutzgrundverordnung nicht vereinbar sind. Je nach Ausprägung können Dark Patterns laut dem Papier gegen ganz unterschiedliche Artikel der DSGVO verstoßen. So etwa gegen die Grundsätze von Fairness und Transparenz oder das Gebot von Datenschutz durch Design und durch datenschutzfreundliche Voreinstellungen. Zudem können eingeholte Einwilligungen unwirksam sein, weil die Anbieter:innen gegen die Anforderungen an die Freiwilligkeit und Informiertheit verstoßen, wenn sie sich die Zustimmung mit Design-Tricks erschleichen.

Um Dark Patterns besser erkennen und verstehen zu können, nehmen die Datenschutzbehörden zudem ein hilfreiche Typologisierung vor. Sie unterscheiden die Design-Tricks in insgesamt sechs Kategorien:

- „Overloading“: Bei dieser Methode werden Nutzer:innen mit so vielen Informationen, Anfragen oder Auswahlmöglichkeiten konfrontiert, dass sie bewusst überfordert werden. In diese Kategorie fällt etwa der Trick des „Privacy-Labyrinths“, bei dem die Datenschutzeinstellungen so kompliziert aufgebaut und versteckt sind, dass es extrem aufwendig ist, sie wie gewünscht zu verstellen.

- „Skipping“: Hierbei werden Auswahlmenüs und -prozesse so kompliziert gestaltet, dass es Nutzer:innen schwer fällt, alle relevanten Aspekte oder ihre ursprüngliche Intention im Blick zu halten und sie deshalb relevante Dinge überspringen. Zum Beispiel bei einem Trick, den die Behörden „trügerische Behaglichkeit“ nennen, bei dem Nutzer:innen durch vorausgewählte Optionen zum Anklicken der weniger datenschutzfreundlichen Option verleitet werden sollen.

- „Stirring“: In diese Kategorie fallen Versuche, Nutzer:innen mit sprachlichen oder visuellen Reizen zu bestimmten Aktionen verführen. So etwa, wenn durch Farben oder andere Formen der graphischen Gestaltung bestimmte Optionen hervorgehoben und andere versteckt werden. Oder wenn Nutzer:innen mit emotionalen Appellen ein schlechtes Gewissen gemacht wird, wenn sie stärkere Datenschutz-Optionen wählen. Oder andersherum, wenn Nutzern mit einem Text zum permanenten Teilen des eigenen Standorts verleitet werden, der dies als besonders soziale Praxis darstellt wird, mit der man die Welt besser machen kann.

- „Hindering“: Hierzu zählen die Datenschutzbehörden Tricks, mit denen Nutzer:innen aktiv an der Ausübung ihrer Datenschutzrechte behindert werden. Zum Beispiel durch sachlich falsche Informationen, durch tote Links oder indem Prozesse länger dauern, als sie eigentlich müssten. So etwa beim Anlegen eines Social-Media-Accounts, wenn Nutzer:innen auf die Angabe bestimmter Daten eigentlich verzichten wollen, jedoch durch die wiederholte Rückfrage „Bist du dir sicher?“ verunsichert und aufgehalten werden.

- „Fickle“: Dies meint Methoden eines bewusst inkonsistenten Designs. Hierzu zählt etwa eine mangelhafte Informationshierarchie, bei der Nutzer:innen an unterschiedlichen Stellen mit scheinbar gleichen oder ähnlichen Informationen und Optionen konfrontiert sind. Dies macht es ihnen unmöglich zu verstehen, wie ihre Daten genau verarbeitet werden. Ein anderes Beispiel sind Datenschutzentscheidungen, die den Nutzer:innen ohne ausreichende Erklärungen und Kontextinformationen vorgesetzt werden.

- „Left in dark“: In dieser Kategorie geht es um bewusst verstecke Informationen und Einstellungsmöglichkeiten, zum Beispiel durch die Verwendung einer anderen Sprache oder vage und uneindeutige Begriffe, statt klarer Beschreibungen. Ein konkretes Beispiel aus der Praxis (das die Datenschutzbehörden allerdings nicht nennen), sind die AGB und Datenschutzbestimmungen von WhatsApp, die bis zu einer Klage der Verbraucherzentralen vor wenigen Jahren nicht auf deutsch vorlagen. Wie das Beispiel der erst kürzlich geänderten AGB zeigt, ist trotz der deutschen Fassung bis heute nicht wirklich zu verstehen, was sie eigentlich aussagen sollen.

Feedback erwünscht

Einen besonders fiesen Design-Trick haben die Datenschutzbehörden in ihrer Aufzählung bislang vergessen: Nicht selten kommt es vor, dass Nutzer:innen bestimmte Entscheidungsfragen bewusst in Momenten vorlegt werden, in denen ihr Nutzungsverhalten darauf schließen lässt, dass sie gerade emotional oder zeitlich gestresst sind, sodass sie keine Ruhe für kluge Entscheidungen haben.

Wer in den Guidelines weitere fehlende Dark Patterns entdeckt oder andere Hinweise zu dem Thema hat, kann den Datenschutzbehörden bis Anfang Mai dazu auf ihrer Website Rückmeldungen geben.

Hilf mit! Mit Deiner finanziellen Hilfe unterstützt Du unabhängigen Journalismus.

0 Commentaires