Staatliche Regulierung habe geholfen, Hassrede auf Twitter signifikant zurückzudrängen. Das hat eine Studie des Leibniz-Zentrums für Europäische Wirtschaftsforschung (ZEW) ergeben. Demnach seien rund zehn Prozent weniger Hasskommentare auf dem sozialen Netzwerk erschienen als vor dem Netzwerkdurchsetzungsgesetz (NetzDG).

Um die gesetzliche Regulierung potenzieller Hassrede in sozialen Netzwerken tobt seit Jahren eine heftige Debatte. Deutschland war 2017 als weltweit erstes Land vorangeprescht und hatte mit dem NetzDG ein so umstrittenes wie wegweisendes Gesetz vorgelegt. Davon erfasste Online-Dienste müssen ihnen gemeldete Inhalte binnen 24 Stunden entfernen, wenn sie offensichtlich illegal sind, bei anderen rechtswidrigen Inhalten gilt eine Frist von sieben Tagen.

Über die Folgen des Gesetzes auf die Meinungsfreiheit im Netz wird weiterhin gestritten – auch vor dem Hintergrund kommender EU-Gesetze wie dem Digital Services Act, dem die deutsche Regelung teils als Vorbild dient. Eine Evaluierung des Bundesjustizministeriums stellte dem NetzDG noch vor dessen Novellierung insgesamt eine gute Note aus, eine unabhängig durchgeführte Untersuchung warnte hingegen vor Overblocking, also vor zu viel ungerechtfertigt gelöschten Inhalten. Zudem stellte sie die praktische Relevanz des NetzDG im Kampf gegen Hassrede in Frage.

Rechtes Hassbiotop

Zumindest letzteren Einwand könnte die ZEW-Studie nun entkräften. Die Forscherinnen Raphaela Andres und Olga Slivko zogen dazu rund 200.000 Accounts von Twitter-Followern der Rechtsaußen-Partei AfD heran. Aus dieser Ecke kommt messbar die meiste Hassrede, sie eignet sich deshalb besonders gut für solche Untersuchungen. Als Kontrollgruppe diente die österreichische FPÖ und deren Follower. Das Nachbarland taugt gut für einen Vergleich, weil es sprachliche und kulturelle Ähnlichkeiten gibt, dort aber dem NetzDG ähnliche Gesetze fehlten.

Die Forscherinnen luden über zwei Millionen Tweets aus 2016 bis 2019 herunter, um Zeiträume vor und nach dem Inkrafttreten des NetzDG untersuchen zu können. Aus dem Material filterten sie Nachrichten heraus, die Begriffe wie „Islam“, „Migra[tion]“ oder „Flucht“ enthielten. Diese Tweets untersuchten sie automatisiert auf die Toxizität. Jeder der Tweets erhielt dann einen Score zwischen 0 und 1. Nachrichten mit einem Score von 0,5 oder höher galten als potenzielle Hassrede. Seit dem NetzDG ging der Studie zufolge die Anzahl solcher Tweets in Deutschland durch die Bank zurück, besonders bemerkbar habe sich dies bei Attacken auf die Identität gemacht.

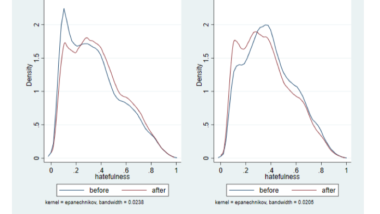

Auch die „Hassintensität“ sei zurückgegangen, im Unterschied zu Österreich. Trotz gewisser Spill-over-Effekte habe sich dort seit dem NetzDG die Verteilung hin zu mehr extremen Tweets verschoben, während in Deutschland insgesamt weniger stark hasserfüllte Inhalte als früher gepostet wurden. Dies spiegle sich auch in absoluten Zahlen wider. Seit der NetzDG-Einführung sei die Anzahl „massiv toxischer“ Tweets um acht Prozent gefallen, solche mit „Identitätsattacken“ um elf Prozent. Da sich polarisierende Inhalte zudem schneller verbreiten als langweilige, habe die bessere Moderation auch zu entsprechend weniger Retweets und damit geringerer Sichtbarkeit von Hasskommentaren geführt, heißt es in der Studie.

Schädliche Effekte abgeschwächt

Zahlreiche Untersuchungen belegen inzwischen, dass Hass im Netz ein ernstzunehmendes Problem ist. Insbesondere bei marginalisierten und deshalb oft angegriffenen Gruppen, etwa Migrant:innen, LGBTQ-Personen oder Frauen, kann es zum Rückzug aus dem digitalen Raum führen, wenn sie online ungebremst attackiert werden. Die Gewalt kann auch als sogenannter „stochastischer Terrorismus“ in den Offline-Bereich überschwappen oder, im Extremfall, gar Genozide befeuern.

Lange sperrten sich die Betreiber der Online-Plattformen gegen Forderungen nach besserer Moderation, Twitter etwa rechtfertigte seine Untätigkeit gegen Hassrede mit der Verteidigung der Meinungsfreiheit. Erst als sich der öffentliche Druck nicht mehr länger wegwischen ließ, gelobten sie Besserung. Doch statt staatlicher Eingriffe ziehen sie bis heute Selbstregulierung und private Gemeinschaftsregeln vor.

Das alleine reiche allerdings nicht aus, schreiben die Autorinnen: Die Anreize für die Betreiber seien schwach, selbst ein „optimales Niveau“ bei der Inhaltemoderation zu erreichen. „Tatsächlich könnte es für die Plattformen optimal sein, extreme Inhalte auf dem Dienst zu belassen, um ihre Nutzer:innenbasis und werbegetriebene Profite zu vergrößern“, heißt es in der Studie.

Umgekehrt würden die Ergebnisse der Untersuchung nahelegen, dass die schädlichen Effekte von Online-Hass abgeschwächt werden könnten, wenn die Online-Dienste stark angereizt werden, rasch auf Meldungen von Hassrede zu reagieren. Seit dem NetzDG drohen davon erfassten Anbietern Geldbußen, wenn sie gegen die Auflagen verstoßen. Verhängt wurden solche Strafen erst zwei Mal, allerdings nicht aufgrund nachlässiger Moderation: Facebook versteckte aus Sicht des Bundesamts für Justiz unrechtmäßig das Meldeformular und legte zudem unvollständige Transparenzberichte vor.

Bessere Meldewege gefordert

Hier sieht die ZEW-Studie noch Potenzial für Verbesserungen. Die Meldewege seien zu komplex, so müssten Nutzer:innen etwa den korrekten Gesetzesparagraphen angeben, wenn sie Hassrede melden möchten. Das könnte abschreckend wirken, schließlich ist der Prozess langwierig und nicht alle sind juristisch ausgebildet.

Auch müssten weitere Studien potenzielle Overblocking-Effekte genauer untersuchen, selbst wenn die Autorinnen keine Hinweise darauf gefunden haben wollen: Abseits der zurückgegangenen Anzahl von Hasspostings rund um Migration und Religion habe sich kein dämpfender Effekt des NetzDG oder eine Verhaltensänderung von Twitter-Nutzer:innen nachweisen lassen. Das NetzDG scheint also laut der Studie, trotz aller Kritik, wirksam gegen Hassrede zu sein.

Hilf mit! Mit Deiner finanziellen Hilfe unterstützt Du unabhängigen Journalismus.

0 Commentaires