Am 24. Februar 2022 hat der russische Angriffskrieg auf die Ukraine begonnen. Seitdem sind Lügen und Propaganda von Russlands Präsident Putin fast täglich in den Nachrichten. Allerdings führt Russland schon seit über einem Jahrzehnt einen intensiven Kampf um die Meinungshoheit im Internet. Besonders beliebt dabei: digitales Astroturfing. Eine breit eingesetzte Propagandamethode, die auf die Beeinflussung von Meinungen und demokratischen Entscheidungen abzielt. Damit steht Russland allerdings nicht alleine da: Viele Staaten nutzen Astroturfing für ihre Zwecke.

Digitales Astroturfing ist mit einer Flut vergleichbar – einer Flut aus Meinungen. Allerdings kommen die Meinungen nicht von der Gesellschaft selbst. Sie kommen aus den Büros von PR-Agenturen, aus Trollfabriken oder Propaganda-Organisationen. Durch Astroturfing sollen die Nutzer:innen den Eindruck gewinnen, dass die künstlich verbreiteten Sichtweisen sehr geläufig sind. Wie neue Studienergebnisse nahelegen, kann sich Astroturfing auf diese Weise auf die Meinungsbildung der Menschen auswirken.

Der Begriff Astroturfing ist von der amerikanischen Firma AstroTurf abgeleitet. Diese stellt Kunstrasen her, der täuschend echt aussehen soll. Klassisches Astroturfing will Graswurzelbewegungen vortäuschen, also so tun, als stecke eine soziale Bewegung hinter den Meinungen. Eine Astroturfing-Kampagne will den Eindruck erwecken, dass eine fabrizierte Meinungsströmung tatsächlich von der Basis der Gesellschaft ausgeht.

Graswurzelbewegungen nachahmen

Astroturfing ist an sich keine neue Sache: Es lassen sich falsche Bürgerbewegungen oder Vereine orchestrieren, so wie das bei der Auseinandersetzung um Stuttgart 21 geschah, wo neben der Bewegung gegen den neuen Bahnhof plötzlich falsche Fürsprecher auftauchten. Oder Firmen versenden vermeintliche Leserbriefe an Medien, um den Anschein zu erwecken, als vertrete die Leser:innenschaft eine bestimmte Meinung.

Im Zuge der Digitalisierung hat sich Astroturfing gewandelt. Im Netz lassen sich fabrizierte Inhalte effizient verbreiten. Es braucht keine Briefe oder Vereinsanmeldungen. Informationen lassen sich leichter verteilen. Schon mit kleinen Teams lassen sich Soziale Medien oder Kommentarsektionen von Nachrichtenseiten beeinflussen.

Die in den letzten Jahren viel diskutierten „Bot“-Accounts spielen dabei allerdings nicht die Rolle, die ihnen oftmals zugeschrieben wurde. So eignen sich automatisierte Accounts meist nur für das künstliche Erhöhen von „Gefällt-mir“-Angaben oder Retweets; authentisches, menschliches Verhalten ahmen sie allerdings scheinbar kaum nach. Dem aktuellem Forschungsstand zufolge scheinen ausreichend ausgereifte Programme schlicht nicht zu existieren.

Selbst wenn es möglich wäre, einzelne Accounts authentisch wirken zu lassen, wiese ein ganzes Netzwerk falscher Accounts wohl weiterhin verräterische Muster auf. Aus diesem Grund scheinen Astroturfing-Organisationen bislang vielmehr auf echte Mitarbeiter:innen gesetzt zu haben, die beispielsweise eine Vielzahl von Accounts in sozialen Medien bedienen. Sie koordinieren die Accounts und deren Aktionen durch interne Kommunikationskanäle.

Ein globales Phänomen

In einer Studie schreiben Wissenschaftler:innen:

Astroturfing ist eine der wirkungsvollsten Bedrohungen des heutigen Internets. Es beschreibt den Prozess der Verschleierung und Verbreitung einer manipulierten Botschaft unter der Gesamtbevölkerung, wobei der Eindruck entsteht, sie komme von ihrer Basis selbst.

Digitales Astroturfing ist ein weltweites Phänomen. Alleine Twitter hat bis Dezember 2021 weltweit über 200 Millionen künstlich verbreitete Tweets verzeichnet. Auf der Karte sind die Länder verzeichnet, in denen laut Twitter Kampagnen aufgedeckt wurden, die von staatlicher Seite oder von mit dem Staat verbundenen Akteuren stammen sollen. Astroturfing-Tweets von anderen Akteur:innen wie Oppositionsgruppen oder von Konzernen veröffentlicht Twitter nicht.

Wie die Twitter-Daten zeigen, gab es auf Twitter bereits eine Menge an digitalen Astroturfing-Kampagnen durch staatliche Akteur:innen. Einige Staaten beschränken sich dabei auf die eigene Bevölkerung. Häufig beinhalten die Kampagnen negative Sichtweisen über die Opposition. Zudem versuchen die Regierungen, ihre eigene Politik und Vorhaben zu legitimieren und positiv darzustellen.

Einige Kampagnen zielen auch auf das Ausland ab und verbreiten polarisierende Inhalte über politische Auseinandersetzungen in anderen Staaten. Des Weiteren versuchen einige Regierungen, eigene Narrative und Sichtweisen auch im Ausland populär zu machen.

Mithilfe von digitalem Astroturfing wird zudem versucht, Demonstrationen und soziale Bewegungen zu schwächen und zu unterdrücken. Beispielsweise hatte China zu Zeit der Protestbewegung in Hongkong eine Astroturfing-Kampagne eingeleitet, um die Demonstrant:innen gesellschaftlich zu diskreditieren und so die Wahrnehmung über die Proteste zu verschlechtern. China versuchte offenbar auch, das eigene Narrativ über die Masseninternierung der uigurischen Minderheit durch eine Kampagne zu verbreiten. Twitter entfernte Ende 2021 entsprechende Accounts und veröffentlichte Informationen zu ihnen.

Auch die Vereinigten Arabischen Emiraten, Ägypten und Saudi Arabien setzten auf umfangreiche Astroturfing-Kampagnen. Dabei nahmen die Staaten offenbar gemeinsam andere Länder ins Visier. Die auf Twitter verbreiteten Narrative richteten sich primär gegen den Iran, Katar sowie auch die Türkei. Astroturfing-Kampagnen des Irans zielten auf die USA sowie Israel. Aus der Türkei gab es Kampagnen zu innenpolitischen Themen, aber auch englischsprachige Tweets, die die türkische Militäroffensive in Syrien in ein positives Licht rücken sollten.

Die schwierige Analyse von Astroturfing

Die Forschung zu Astroturfing ist schwierig. Normalerweise gewähren Soziale Netzwerke Wissenschaftler:innen und Journalist:innen nur ungenügend Zugang zu ihren Programmierschnittstellen oder gehen sogar rechtlich gegen Forschende vor. Darüber hinaus sind die Zugänge oftmals sehr teuer.

Auch in sozialen Netzwerken erfolgen Archivierungen über das Internet Archive oder anderen Archivierungsprojekten eher lückenhaft. Beispielsweise sind Inhalte aus geschlossenen Nutzergruppen von sozialen Medien nicht einfach zugänglich. Hinzu kommt die gängige Praxis sozialer Netzwerke wie Facebook, Astroturfing-Inhalte schlicht zu löschen. Dies dämmt die Kampagnen zwar ein, erschwert aber ihre Erforschung. Twitter veröffentlicht immerhin die Tweets staatlicher Astroturfing- und Desinformationsaktivitäten – allerdings oft mit langer Verzögerung.

Auch die initiale Erkennung von Astroturfing-Kampagnen ist oft eine große Hürde. Beispielsweise flog eine Astroturfing-Kampagne in Südkorea nur auf, da Ermittler:innen beteiligte Account-Namen auf dem Computer einer Geheimdienst-Agentin sicherstellten. Viele wissenschaftliche Untersuchungen basieren meist auf zuvor enthüllten Kampagnen, zu denen bereits Informationen verfügbar sind.

Propaganda ja, aber doch nicht am Wochenende

Im Rahmen einer kürzlich erschienenen Studie entwickelten Wissenschaftler:innen eine Analyse-Möglichkeit, um Astroturfing-Kampagnen ohne solche vorherigen Erkenntnisse zu identifizieren. Dabei hoben sie hervor, dass Accounts nicht individuell, sondern als Netzwerk betrachtet werden sollten. An dem Verhalten des Account-Clusters lasse sich dann ermitteln, ob es sich um eine echte Bewegung oder eine Astroturfing-Kampagne handelt.

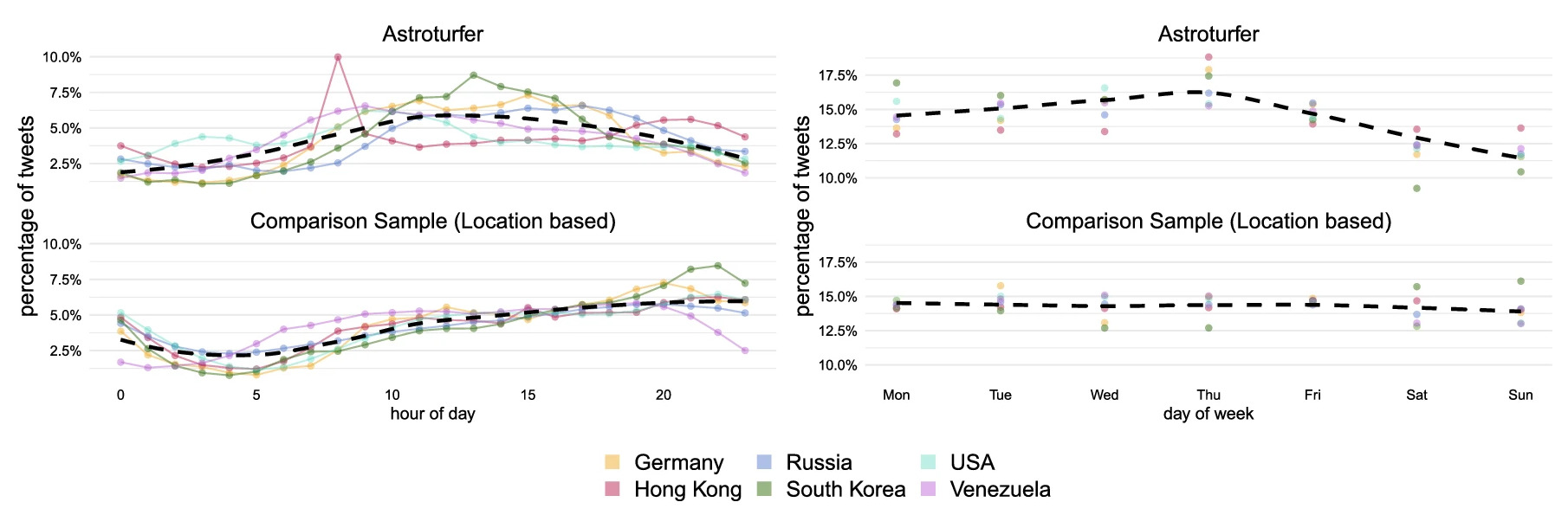

Ausgehend von früheren Kampagnen konnten sie dazu typische Verhaltensweisen von Netzwerken an Astroturfing-Accounts ermitteln. Wie auf der Grafik zusehen ist, verbreiteten Mitarbeiter:innen von Astroturfing-Organisationen ihre Inhalte häufig zu üblichen Arbeitszeiten unter der Woche. Auch kam es vor, dass die Astroturfing-Accounts ihr Verhalten zeitgleich ändern – mutmaßlich auf Anweisung der Organisatoren.

Wie die Forscher:innen außerdem erklären, stehen die Mitarbeiter:innen einer Astroturfing-Organisation häufig nicht ganz hinter den Narrativen der Kampagne. Daher würden sie meist bloß versuchen, die Mindestanzahl an beispielsweise Kommentaren zu verfassen. Damit würden sie keinen Grund haben, ihre Accounts über die gesetzten Anforderungen hinaus zu individualisieren. Dies ergebe Account-Cluster mit großen Ähnlichkeiten im Verhalten und Auftreten. Aus diesen Indizien konnten die Wissenschaftler:innen eine Methode basteln, um Hinweise auf Astroturfing-Kampagnen zu finden.

Die Internet Research Agency

Mein erstes Gefühl war, dass ich einer Art Fabrik gelandet war. Eine Fabrik in der Lügen und Unwahrheiten in industrielle Fließbandarbeit gewandelt wurden.

Mit diesen Worten beschrieb ein ehemaliger Angestellter der russischen Astroturfing-Organisation „Internet Research Agency“ seinen Arbeitsplatz. Die Agentur begann ihre Aktivitäten auf Twitter bereits 2009 und ist in Deutschland unter dem Namen „Trollfabrik“ bekannt. Seit 2013 verbreitet sie vermehrt in verschiedenen Ecken des Internets pro-russische Narrative. Von ihren aufgedeckten Aktivitäten ließ sich bislang nur ein kleiner Teil wissenschaftlich aufarbeiten.

Twitter veröffentlichte Daten mit 3.841 Twitter-Accounts, die der Konzern der Trollfabrik zuordnete und die zur US-Wahl 2016 genutzt wurden. Ebenso wie auf Twitter trat die Agentur auch bei Google und Facebook in Erscheinung. Anwälte von Google, Facebook und Twitter geben an, dass rund um die US-Wahl 2016 wahrscheinlich über 150 Millionen Menschen der russischen Propaganda ausgesetzt waren.

Schon 2014 berichtete die Süddeutsche Zeitung unter Berufung auf geleakte Dokumente, dass die Internet Reseach Agency in dieser frühen Phase bis zu 600 Mitarbeitende hatte. Ihr monatliches Budget habe damals bei einer Millionen US-Dollar gelegen.

Die Accounts hatten in ihrer Qualität und Authentizität große Unterschiede. So waren einige Accounts nur dazu da, massenhaft Kommentare zu hinterlassen. Daher verwendete die Agentur nur wenig Ressourcen, um jene glaubhaft erscheinen zu lassen. Andere Accounts bauten ihre Mitarbeiter:innen über längere Zeit auf, um ihnen größere Authentizität verleihen zu können. Der Twitter-Account der vermeintlichen rechten Influencerin „Jenna Abrams“ war so einer:

Mit ihren über 70.000 Follower:innen hatte die Kunstpersona der Agentur eine größere Reichweite als der heutige Redaktionsaccount von netzpolitik.org. Aktiv seit 2014, soll Abrams zu Beginn allerdings vorwiegend unterhaltsame Inhalte verbreitet haben – wohl um ihre Follower:innenschaft aufzubauen. Allmählich änderte sich ihr Verhalten allerdings: Sie verbreite zunehemend polarisierende, rechtskonservative Inhalte.

Wissenschaftler:innen haben den Account untersucht. Mit diesem soll die Internet Research Agency versucht haben, eine direkte Beziehung mit den Nutzer:innen aufzubauen. Diese habe sie mit großem Aufwand gepflegt. Nach den ausgewerteten Tweets streute „Jenna“ dabei neben vielen belanglosen Inhalten kontinuierlich politische Botschaften ein, die auf den Weltbildern konservativer US-Amerikaner aufbauten. Übersetzte Beispiele für solche Tweets sind:

Einen schönen Dienstag meine Freunde und denkt dran, es sind nur noch 416 Tage, bis Obama sein Amt verliert.

Dieser seltsame Moment, wenn man einen Trump-Befürworter nicht als misogynistischen, weißen Rechtsextemen bezeichnen kann.

Hallo, ich bin Ahmed! Ich kann dich oder deine Schwester vergewaltigen und komme damit durch, weil #refugeeswelcome

Es sind fast 8 Jahre Obama und die Leute wissen nicht, welche Toilette sie benutzen sollen.

Heuchler-Starterpaket: 1. Kandidiere gegen die Korruption der Wall Street 2. Unterstütze Hillary Clinton

Die Agentur betrieb zudem noch deutlich extremere Accounts. So betreute sie unter anderem @Jihadist2ndWife, einen islamophoben Parodie-Account, oder @PeeOnHillary, welcher Nutzer:innen dazu motivierte, ein Video hochzuladen, wie sie auf ein Foto von Hillary Clinton urinieren.

Digitales Astroturfing in Perfektion

Die zitierten Tweets stehen exemplarisch dafür, was die Internet Research Agency – und damit letztlich der Kreml – unter anderem erreichen möchte: die westliche Gesellschaft spalten. Dazu stachelte die Agentur allerdings nicht nur die konservative Seite an – sie sprang auch auf linksorientierte Strömungen auf.

So fanden Wissenschaftler:innen in einer quantitativen Analyse aller Tweets ihrer zur US-Wahl 2016 betriebenen Accounts, dass sie sowohl populäre Hashtags wie #MAGA oder #IslamKills aus dem rechten als auch #PoliceBrutality oder #BlackLivesMatter aus dem linken Spektrum verbreitete. Insgesamt fanden die Wissenschaftler:innen ein Ungleichgewicht: Konservative Stimmen verstärkte die Trollfabrik stärker. Zudem kam es vor, dass die vermeintlich linken Accounts der Agentur von ihrem linken Kurs abwichen. Beispielsweise waren knapp die Hälfte der Tweets „linker Accounts“ über die demokratische Präsidentschaftskandidatin Hillary Clinton, die 2013 noch die beliebteste Politikerin der USA gewesen war, negativer Natur.

Aufgrund Twitters zugehöriger Veröffentlichungen ließ sich die Astroturfing-Kampagne der Organisation auf Twitter aufarbeiten. Ihre Aktivitäten ließen sich aber in allen möglichen Ecken des Internets wie Facebook, Twitter, Instagram, Stitcher, YouTube, Reddit, LinkedIn und verschiedenen anderen Webseiten nachweisen.

Krönung der Spaltungsversuche

2017 kam heraus, dass die Internet Research Agency gleichzeitig eine islamophobe Demonstration und eine Gegendemonstration im Netz beworben haben soll. So kündigte die Agentur über die von ihr kontrollierte rechtsorientierte Facebook-Gruppe „Heart of Texas“ mit 250.000 Follower:innen eine Demonstration an, um „die Islamisierung von Texas zu stoppen“. Gleichzeitig bewarb sie auch die Gegendemonstration “Islamisches Wissen retten” über ihre Facebook-Gruppe „United Muslims of America“.

Die Agentur übte ihre Propagandaaktivitäten auch in Deutschland aus. Die auf Twitter bis 2018 verzeichnete Astroturfing-Kampagne war allerdings relativ klein. Es handelte sich um 102.657 Tweets durch 111 Accounts. Inhaltlich soll die Kampagne ähnlich wie jene in den USA zum Ziel gehabt haben, die gesellschaftliche Spaltung voranzutreiben.

Auch die Ukraine war schon lange Zielregion der Kreml-Propaganda. So ergab eine Untersuchung ihrer Aktivitäten, dass die Agentur unter anderem Falschinformationen über vermeintliche Kriegsverbrechen und Atomreaktorunfälle in der Ukraine verbreitet hatte. Übereinstimmendes haben Whistleblower bereits 2015 der New York Times berichtet. Auch ein Forbes-Artikel klärte schon 2014 über die russische Astroturfing-Kampagne zum Ukraine-Konflikt auf. Zur selben Zeit meldete der Guardian, im Falle von Artikeln über die Ukraine täglich Tausende pro-russische Kommentare zu erhalten.

Für Schmerzmittel und Braunkohle

Astroturfing lässt sich auch im kommerziellen Bereich anwenden. Ein bekanntes Beispiel für einen solchen Einsatz stellt die Lobby-Arbeit des Pharmakonzerns Purdue dar. Der Konzern orchestrierte zusammen mit anderen Firmen eine Astroturfing-Kampagne, um für das Opioid OxyContin zu werben. Purdue wird vorgeworfen, maßgeblich zur amerikanischen „Opioid-Epidemie“ beigetragen zu haben.

In Deutschland enthüllte LobbyControl schon 2009, dass die Deutsche Bahn für verdeckte Werbung bezahlte. So wurden etwa in den Kommentarsektionen von Medien wie dem Spiegel massenhaft Kommentare hinterlassen, die eine Privatisierung zu befürworten. Die Braunkohlelobby hatte laut Recherchen von Lobbycontrol enge Verbindungen zur „Bürger“-Initiative „Unser Revier“, die ähnliche Positionen wie Braunkohleverbände vertrat, so die Transparenzorganisation.

Eine aktuelle Astroturfing-Kampagne kommt von einem Konzern, der selbst gegen digitales Astroturfing vorgeht – von Facebook. Der Konzern soll die Agentur Targeted Victory dafür bezahlt haben, durch Astroturfing seinen Konkurrenten TikTok zu schwächen. Dazu soll die Agentur unter anderem Leserbriefe von „besorgten Eltern“ an die Zeitung Denver Post geschickt haben. Ähnliche Briefe ließen sich auch bei anderen Medien finden. Des Weiteren soll die Agentur ihre Mitarbeiter:innen dazu aufgefordert haben, Geschichten über angeblich gefährliche TikTok-Trends an lokale Medien zu schicken, um sie auf diese Weise zur entsprechenden Berichterstattung zu bewegen.

Kann Astroturfing tatsächlich wirken?

Die Wirkung von Astroturfing-Kampagnen ist bisher noch nicht umfassend erforscht. Nichtsdestotrotz gibt es neue Erkentnisse aus dem deutschen Sprachraum. Wissenschaftler:innen haben dazu in zwei Experimenten die Wirkung russischer Propaganda durch Astroturfing-Kommentare untersucht.

Als Gesamtergebnis stellten die Forscher:innen heraus, dass manipulative Kommentare Wirkung zeigen können. „Zwei Astroturfing-Kommentare mit Zweifel über die russische Verantwortlichkeit bezüglich den negativen Ereignissen reichten aus, um die Wahrnehmung der Leser hinsichtlich der öffentlichen Meinung zu verzerren“, erklären die Wissenschaftler in der neueren der beiden Studien.

Dies geht mit früheren Erkentnissen aus der Psychologie einher: Denken Menschen, dass es einen sozialen Konsens für eine bestimmte Haltung gibt, kann dies Auswirkungen auf ihre Meinung haben. So weisen Studien darauf hin, dass Menschen ihre Meinung eher festhalten, wenn sie einen sozialen Konsens für jene wahrnehmen.

Sprung in die Medien

Eine gut umgesetzte Astroturfing-Kampagne kann auch die Medienwelt beeinflussen – mit erheblichen Folgen. Berichten Medien über Inhalte, die eigentlich aus den Büros einer Astroturfing-Organisation stammen, ist eine wichtige Schwelle überschritten. Nun erreicht die Kampagne auch Menschen, die beispielsweise über das Internet nur schwer erreichbar waren. Beispielsweise hatten einige etablierte Medien, wie CNN, BBC, die Washington Post oder die New York Times Aussagen des von der Internet Research Agency angeleiteten Astroturfing-Accounts Jenna Abrams zitiert. Auf diese Weise erhöhte sich ihre Reichweite stark.

Wissenschaftler:innen haben dieses Phänomen unter die Lupe genommen: Ihre Untersuchung ergab, dass 71 der 117 der untersuchten Nachrichtenanbietern zwischen 2015 und 2017 mindestens einen Tweet der Internet Research Agency zitiert hatten – in insgesamt 314 Nachrichtenmeldungen fanden sie Verweise auf Tweets der russischen Propaganda-Agentur.

Astroturfing als Angriff

Letztlich zeigt sich, dass digitale Astroturfing-Kampagnen keineswegs unterschätzt werden sollten – weder in ihrem Umfang, noch in ihrer Wirkung. Mit Astroturfing lassen sich demokratische Prozesse, Werte und Systeme stören, manipulieren und angreifen. Auf Dauer könnte das schwere Folgen haben, schreibt Corneliu Bjola, Professor für Diplomatiestudien an der Universität Oxford, zu digitaler Propaganda:

Ob durch das Aufhetzen politischer Unruhe, die Beeinflussung von Wahlausgängen oder die Schwächung des Staatswesens – digitale Propaganda hat inzwischen einen Punkt erreicht, an dem ihre langfristigen Folgen für das Staatsgeschehen wohl genauso groß sein können wie ein klassischer militärischer Angriff.

Dass militärische Kriege und Informationskriege zusammengehen, zeigt sich nun auch im russischen Angriffskrieg auf die Ukraine. Die Raketen und Bomben werden von einem Kampf um die Hoheit über die Informationen begleitet. Russland nutzt dabei das ganze Arsenal von Zensur bis Astoturfing. Die ukrainische Seite setzt auf die Potenziale von Emotionen und Memes. Es gibt pro-ukrainische und pro-russische Desinformation, die auch von ganz normalen Nutzer:innen verbreitet wird.

Letztlich bleibt den Nutzer:innen von sozialen Netzwerken in allen Fällen nichts anderes übrig, als vorsichtig zu sein – besonders, wenn plötzlich alle einer Meinung zu sein scheinen.

Hilf mit! Mit Deiner finanziellen Hilfe unterstützt Du unabhängigen Journalismus.

0 Commentaires